機械学習のニューラルネットワークにおいて、活性化関数は欠かせない要素の1つです。しかし、その役割や必要性について理解できていない人も多いのではないでしょうか。そこで本記事では、活性化関数の必要性と役割について分かりやすく解説します。機械学習やディープラーニングに興味がある人はぜひ読み進めてみてください。

活性化関数の役割

ニューラルネットワークにおいて、中間層と出力層における活性化関数の役割は異なります。

中間層における活性化関数の役割

中間層における活性化関数の主な役割は、入力されたデータに非線形性を持たせることです。中間層は、入力層からのデータを受け取り、ニューロンの重み付け和を計算し、それを次の層に伝えます。しかし、線形関数だけを使用する場合、重み付け和もまた線形的になってしまい、ニューラルネットワーク全体が線形モデルになってしまいます。活性化関数に非線形関数を使用することで、中間層の出力を非線形に変換することができます。これにより、ニューラルネットワークは非線形モデルとして機能し、より複雑なデータの表現が可能になります。

出力層における活性化関数の役割

出力層における活性化関数の役割は、ニューラルネットワークの出力を所望の形に変換することです。具体的には、分類タスクにおいては、各クラスに対応する確率値を出力するために、活性化関数としてSoftmax関数が使用されます。

また、回帰タスクにおいては、出力層に活性化関数を使用することもありますが、一般的には活性化関数を使用しない線形層が出力層に配置されます。線形層を使用することで、ニューラルネットワークの出力が制限されず、任意の値を出力できるため、回帰タスクに適した構造となります。

活性化関数の種類と使い分け

それぞれの活性化関数の特徴と使いどころを以下にまとめます。

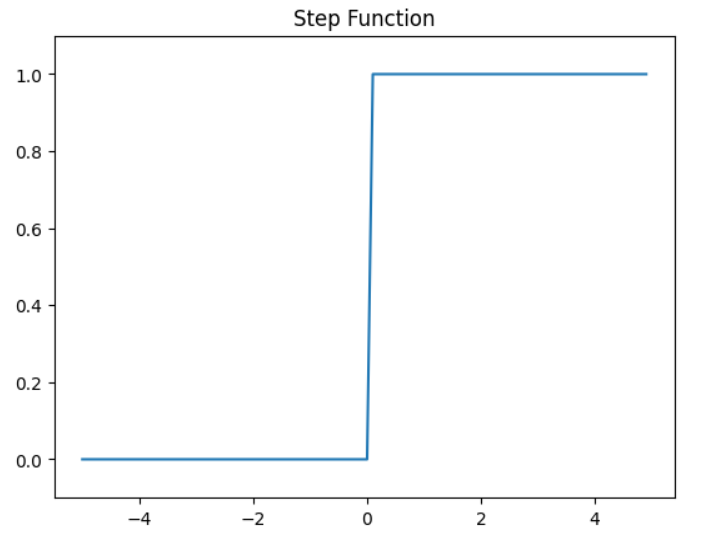

ステップ関数

- 特徴:入力値が0以下の場合は出力が0、0より大きい場合は1を返す

- 用途:二値分類タスクなどで使用される

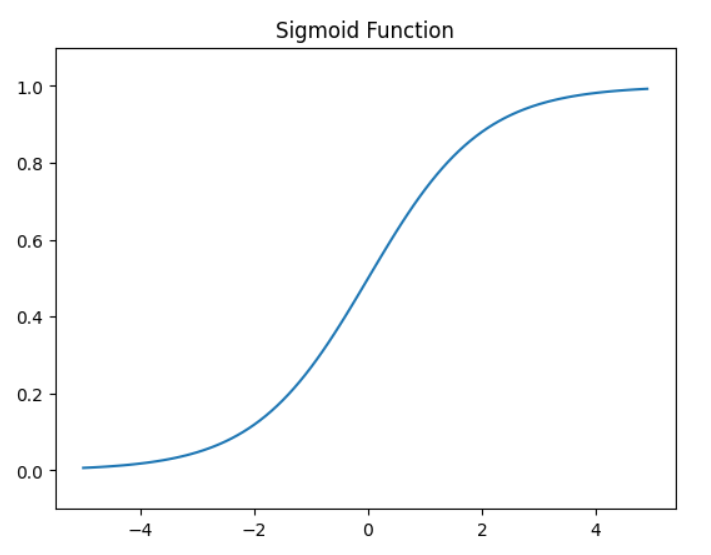

シグモイド関数

- 特徴:入力値が大きくなるにつれて0または1に収束するS字曲線の形状を持つ

- 用途:二値分類タスクや多値分類タスク、ニューラルネットワークにおける中間層の活性化関数として使用される

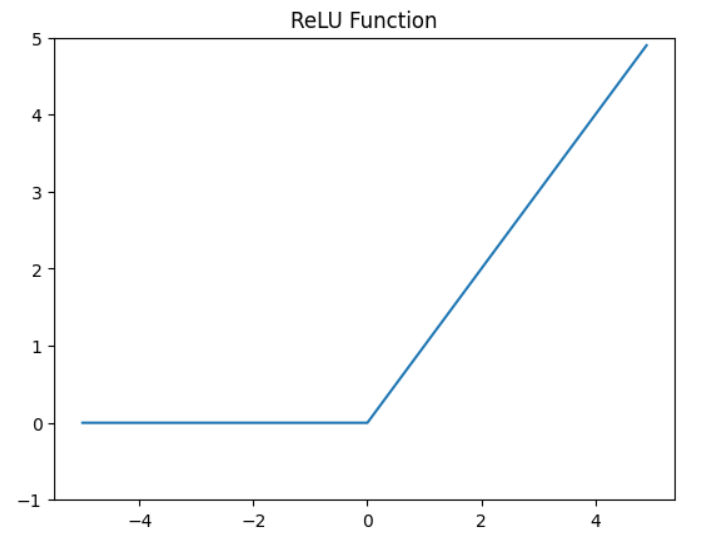

ReLU関数

- 特徴:入力値が0以下の場合は0を返し、0より大きい場合は入力値をそのまま返す

- 用途:ニューラルネットワークにおける中間層の活性化関数として最もよく使われる

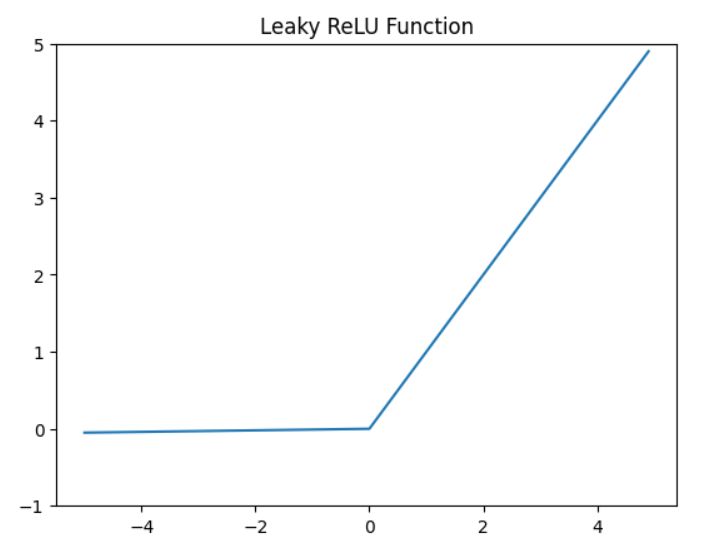

Leaky ReLU関数

- 特徴:入力値が0以下の場合は小さな傾きを持つ直線的な関数を返し、0より大きい場合は入力値をそのまま返す

- 用途:ReLU関数で生じる「死のReLU問題」を回避するために使用される

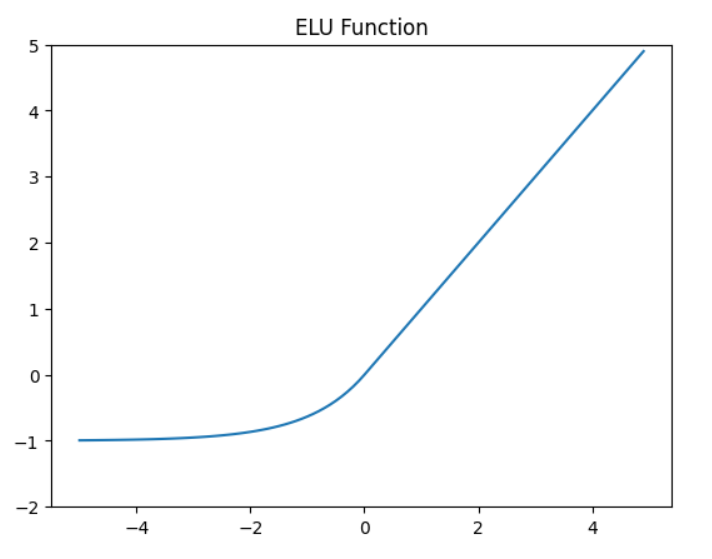

ELU関数

- 特徴:シグモイド関数とReLU関数の特徴を併せ持った関数で、入力値が0以下の場合でも小さな傾きを持つS字曲線を返す

- 用途:中間層や出力層の活性化関数として使用される。特に、学習が収束しやすくなるため、多層ニューラルネットワークの深さが増すにつれて使用されることが多くなる。

活性化関数の必要性

活性化関数を使わない場合の問題点

活性化関数を使わない場合の問題点は、単純な線形関数しか表現できず、ニューラルネットワークの表現力が制限されることです。そのため、ニューラルネットワークが複雑な非線形関数を表現できるように、活性化関数が導入されます。

活性化関数による性能向上の具体例

活性化関数による性能向上の具体例としては、画像認識の分野での成果が挙げられます。例えば、従来の手法では人間でも認識が難しいような画像でも、ディープラーニングを用いたアプローチにより高い精度で認識できるようになりました。また、自然言語処理の分野でも、活性化関数を用いたニューラルネットワークにより、より自然な文の生成や意味解析が可能になっています。

まとめ

活性化関数は、ニューラルネットワークにおいて重要な役割を担っています。今後はより高度なニューラルネットワークの構築が求められることから、より優れた活性化関数が開発される可能性があります。また、活性化関数を自動的に最適化する方法も注目されており、より効率的な機械学習手法が生まれることが期待されるでしょう。活性化関数の発展によって、機械学習の性能向上が期待されています。

コメント