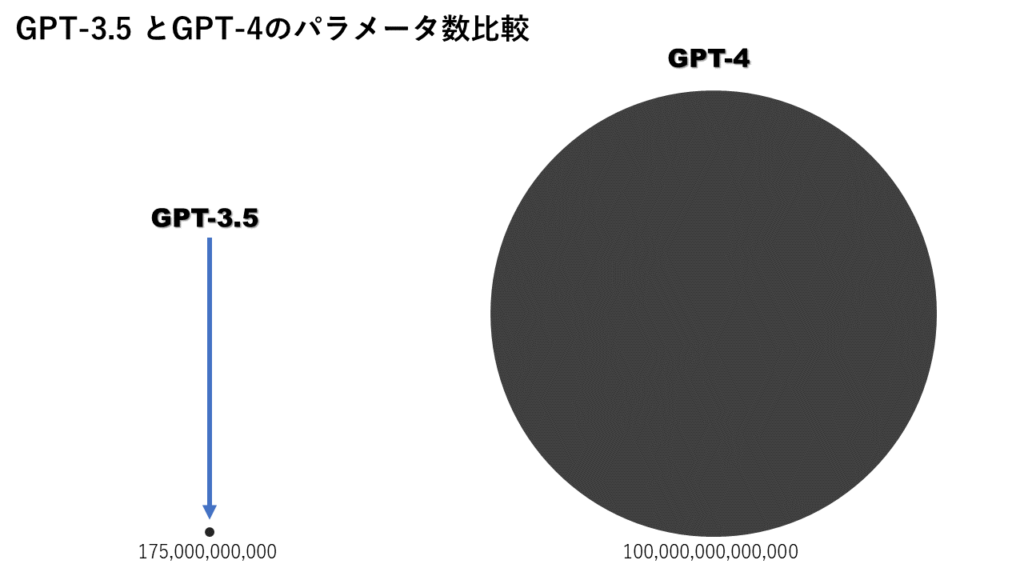

大規模言語モデルであるChatGPTはGPT3.5がベースになっており、GPT3.5のパラメータ数は1750億個です。その次世代モデルのGPT-4ではその500倍である100兆個のパラメータを持つと言われています。

これを聞いてあなたはこう思ったでしょう。「パラメータ数ってなんやねん!」

この記事ではパラメータ数について初心者にでもわかりやすく解説していきます。最後まで読んでパラメータ数の謎を解いていきましょう。

パラメータ数とはなにか

パラメータ数とは、機械学習モデルが学習中に最適化する必要のある変数の数を指します。これらの変数は、モデルが入力データを処理し、予測や生成を行う際に使用されます。モデルのパラメータは、学習データを使って最適な値を見つけ出すことにより、モデルの性能を向上させるために調整されます。

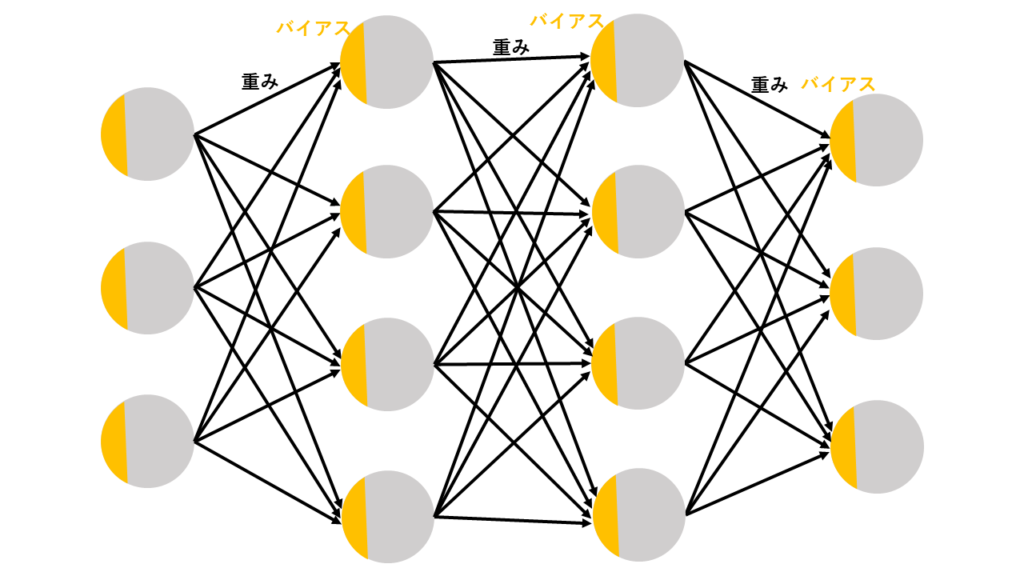

例えば、ニューラルネットワークの場合、重み(ウェイト)やバイアス(バイアス)というパラメータがあります。これらのパラメータは、ネットワークの構造によって異なりますが、それぞれのニューロンが持つ重みやバイアスの値が学習によって最適化され、モデルの性能を向上させる役割を果たします。

パラメータ数はモデルの複雑さを表し、多いほどモデルがより複雑な関数を学習することができますが、学習に必要な計算リソースが増えたり、過学習のリスクが高まったりするというデメリットもあります。適切なパラメータ数を選択することがモデルの性能を最大化するために重要です。

パラメータ数が多いとどうなるか

パラメータ数が多いほどモデルの性能が良いとされていますが、多いことでの増える課題もあります。そこでパラメータ数が多いことでのメリットとデメリットをまとめてみました。

モデルのパラメータ数が多いと

〇 複雑なタスクに対しても高い性能を発揮できる

〇 複雑なモデルを学習することができるため、高度な特徴抽出や表現学習が可能になる

〇 より大規模なデータセットを学習することができるため、より高い汎化性能を持つことができる

× 学習にかかる時間や計算リソースが増加するため、学習や推論に高性能なハードウェアが必要になる

× モデルのサイズが大きくなるため、ストレージやメモリの容量が必要になる

× 過学習のリスクが高まる可能性があり、適切なモデルの正則化やチューニングが必要になることがある

× モデルの解釈性が低くなる可能性があり、ブラックボックス化されることがある

パラメータ数をわかりやすくのものに例えると…

ここまでパラメータ数がなにか、多いことでのメリット・デメリットを解説していきましたが、あまりイメージを持てない方もいるかもしれません。そこでパラメータ数を日常のものに例えて説明していきます。

例1 料理の材料の数

パラメータ数を料理に例えると「レシピの材料の数」と考えることができます。

材料が多いと、より多彩な味や食感を表現することができます。さらに、より複雑な料理を作ることができるため、高いクオリティの料理を作ることができるようになります。

しかし、料理の材料の数が増えることにより以下のことが起こります。

- 準備や調理に時間や手間がかかる

- 材料の種類や調達の難しさにより、コストが高くなる可能性がある

- 材料が多いことにより、調理過程が複雑になり、ミスが生じる可能性がある

例2 建物の部屋の数

2つ目に建物の部屋の数で例えて説明していきます。

例えば、一つの建物にたくさんの部屋がある場合、それぞれの部屋には異なる機能があります。リビングルームはくつろぎのスペースであり、キッチンは料理をするスペース、ベッドルームは寝るスペースといったように、それぞれの部屋が異なる役割を果たします。

このように、建物の部屋の数が多いほど、異なる機能を持ったスペースが増え、より多様な用途や機能を実現できるようになります。一方で、部屋の数が増えることで、建物全体のサイズや複雑さが増し、メンテナンスや管理が難しくなる可能性もあります。

まとめ

この記事ではAIにおけるパラメータ数について解説してきました。パラメータ数が多いことでより高い性能を発揮できるが、学習に時間がかかってしまったり、モデルが複雑になってしまったりします。

これらの視点を考慮しながら、実際にモデルを作るときはパラメータ数を適切に設定することが、モデルの応用や活用を最適化する上で重要です。タスクや用途に応じて、パラメータ数を調整することで、最適な性能やコスト効率を実現することができます。

コメント